![[Home]](/static/root.gif)

Cлучайно наткнулся тут на тестирование велосипедных цепей на разрыв, чучуть более актуальное чем гост советских времен Connex_Breaking_Load_Test_Results.pdf, вобщем по сравнению с гостом все даже получше стало, что вобщем то не сильно меня удивило учитывая современные тракторные передачи.

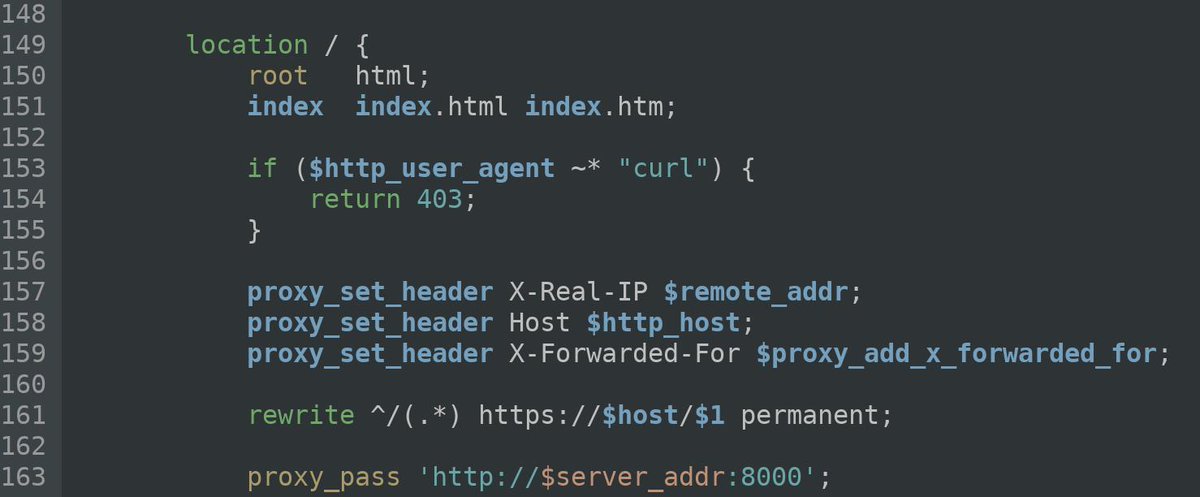

--- Уязвимости в Cisco RV32x были устранены через блокировку запросов от утилиты curl.

Исследователи из компании RedTeam Pentesting обнаружили, что компания Cisco лишь создала видимость устранения уязвимостей в выпущенном в январе обновлении прошивки к маршрутизаторам Cisco RV320 и RV325. Вместо реального устранения проблем в скриптах web-интерфейса, в обновлении прошивки были внесены изменения в настройки http-сервера nginx, блокирующие обращение при помощи утилиты curl, которая использовалась в прототипе эксплоита и примерах для проверки наличия уязвимости.

После установки обновления прошивки с "устранением" проблем, устройства Cisco RV32x как и раньше остаются уязвимыми. Для атаки достаточно сменить значение User-Agent при помощи ключа "-A", например:

curl -s -k -A kurl -X POST --data 'submitbkconfig=0' https://192.168.1.1/cgi-bin/config.exp

Неисправленными остаются три уязвимости. Две проблемы (CVE-2019-1653) позволяют без аутентификации обратиться к скриптам config.exp или export_debug_msg.exp с флагом "submitbkconfig" и получить содержимое файла конфигурации устройства, включая хэши паролей доступа, и ключи к VPN и IPsec. При запросе через export_debug_msg.exp конфигурация отдаётся в зашифрованном виде, но для шифрования использован фиксированный пароль, присутствующий в прошивке ('NKDebug12#$%'). Третья уязвимость (CVE-2019-1652) позволяет выполнить любую команду в системном окружении устройства через манипуляции с параметрами в форме генерации сертфикатов (например, вместо имени можно указать "'a\$(ping -c 4 192.168.1.2)'b").

Поражает наивность реакции Cisco:

Предполагаю, что под "complete fix" они понимают блокировку User-Agent "kurl", используемый в новом примере атаки😊

И заметье, на подготовку такого патча им потребовалось полгода:

Ещё доставляет реклама этих рутеров на сайте Cisco:

Хоть это и мыльница и скорее всего ваще не их но тем не менее Ебаныйстыд!!!

Лазал я тут по ебею, и неожиданно попался моему взору juniper J 4350, за 5 тыщь вместе с доставкой - погуглил/почитал - по сути своей это софтроутер, по железу ни что иное как обычный четвертый пень в немного необычном конструктиве, унутри сплошной тантал - ломаца можно сказать нечему, за пару баксов с того же ебея можно туда вотнуть проц на 3.8GHz и памяти до 4 гигов, правда заюзать можно только 3.5 ибо i686, ну да не суть и того хватает с головой, вобщем во всех отношениях пиздатый аппарат😊 voip только можно сказать отсутствует, но с этим у жуниреров всегда было никак, есть какието платы пашущие тока с аваевским CM который мне нах не нужен, но с этим я решил смирица приставив сбоку циску с голосовыми портами, ктому же она у меня итак есть, ну и взял я его вобщем.

До него у меня дома роутером была cisco 2851, впринципе никаких проблем с ней небыло - всем хороша, кроме ната - больное место всех бранчевых кошек, торренты нисчадно его насиловали плодя тысячи сессий как я гайки(таймауты) там ни закручивал - всеравно периодически это ушатывало ее сраный процессор от калькулятора ситизен в полку😊 Это тоже от части способствовало покупке жунипера, у него заявлено 225килопакетов/с и 250к сессий на коробку с 2 гигами оперативы и какаято умопомрачительная по цискиным меркам цифра в 10000 новых сессий в секунду😊 у кошки просто 10000 сессий на нате уже проблема, если в секунду это уже пиздец ей в ту же секунду😊 Ну нада думать, калькулятор VS четвертый пень, хоть и селерон там на 2.53GHz но всеравно небо и земля😊 На практике вобщем то так и получилось - он этих торентов ваще никак не ощющает - что есть что нет - разница в загрузке плавает в районе 5 процентов. Кучу времени потратил на поиски софта - роутер приехал с убитой флешкой, не мог даже загрузица, заменить не проблема - там обычная CF на гиг-два пойдет а вот софт найти оказалось не так просто - довольно таки древний аппарат который вытеснили SRX'ы у которых ноги вобщем то и растут из J серии, точнее так то он по сути не сильно древний - поддержку дропнули тока в 2018 году, и софт есть на торрентах, но это архивы для установки уже поверх существующей системы, а вот чтоп с нуля на флэшку можно было закатать пришлось поискать, но в итоге все получилось - Juniper links все работает, после недельного траха с тоннелем на работу😊 Об этом и хочу рассказать😊

Вобщем нужен мне тоннель на работу, поверх которого у меня BGP почти прямо в кору в бэкбон. Дома у меня динамический серый IP. Все было легко и просто когда была кошка, так как с другой стороны тоже была кошка - все работало сполпинка поверх dmvpn что не удивительно ибо кошка с кошкой и кошковский dmvpn для такого и предназначен😊 Но тут вместо кошки жунипер - и резко возникает вопрос - КАК БЛЯТЬ ТЕПЕРЬ ЗДЕЛАТЬ этот сраный тоннель😊 Я не спец по всяким бранчевым решениям, у меня большие сети, большие маршрутизаторы, и физические каналы, а всякие vpn это все не мое, но тем не менее я сетевик - почитал порыл - задолбался - милионы блять howto и примеров как зделать практически любые тоннели между кошкой и джунипером да и не тока, но без динамических IP и ната - ну да блять, там и делать то нехер - прописал с двух сторон хоть гре хоть ipip да что угодно - и постят эти howto кругом, кому они нах нужны тока, а вот с динамикой из за ната уже все не так просто😊 В итоге я понял что блять единственный интероперабельный вариант в такой ситуации это IPSEC в туннельном режиме. Никогда до этого не ковырял IPSEC, попробовал вывернуца приставив сбоку кошку за джунипером - но DMVPN споткнулся на двойном нате, пришлось таки в срочном порядке осваивать IPSEC😊

На джунипере как ни странно все оказалось достаточно просто, а вот со стороны кошки постоянно получались какието косяки😊 Собственно сам IPSEC поднять получилось без проблем, проблемы возникали с тоннелем😊 У кошки вариантов этого ипсека тьма на все случаи жизни, если с другой стороны кошковское же решение😊 а вот если нет то начинаюца нестыковки😊

Сначала затык вышел с IPSEC внутри VRF😊 У меня там по сути был так называемый Front Door VPN - тоесть один конец тоннеля торчит в VRF c интернетом, другой в VRF с бэкбоном, так вот IPSEC в VRF не заработал, в global работал, в VRF нет - видать баг иоса какой то потому что дома так работал как и написано у кошки, а где нада нет😊

Так как там где нада это была не основная задача а иос подбираеца под основную таки - пришлось все это дело оттуда вообще вынести на какуюнить другую подходящую хрень😊 Подходящая хрень в виде древней ободранной и страшной как сама моя жизнь циски 3725 нашлась под чьим то столом, в состоянии "пинали лет 5 ногами" пока она там валялась, но тем не менее она включилась, матерясь на хренова крутящиеся вентиляторы, нада отдать ей должное😊 вентиляторы смазал😊 через пару дней смазка видать попала куда нада и мат убрался😊 В добавок таким образом надобность в одном vrf отпала и интернет я засунул в global дабы не усложнять себе жизнь😊

В итоге первое что реально заработало на ней собсно IPSEC через cryptomap на интерфейсе, с двумя ip на концах и поверх этого GRE тоннель - работает, но не красиво ибо умом то понимаеш что GRE тут лишний оверхед, а мне и сам IPSEC тоже лишний оверхед ибо шифровать мне там нечего - нужен только транспорт - нада убрать значит😊 Начал искать как - нарыл кошкин DVTI aka Dynamic Virtula Interface - вроде бы что нужно - жунипер судя по всему имеет то же самое и может гонять routing protocol прямо поверх тунельного интерфейса.

Но и тут вышел косяк - если в proxy identify вписать какой то конкретный ip то все работает, но со стороны жунипера шифруеца не весь траффик попадающий в интерфейс а только тот что попадает в proxy identify - тоесть route based VPN нихрена не получается. Если в proxy identify поставить 0.0.0.0/0 как и должно быть то интерфейс поднимался, но без роутинга - тоесть кошка без понятия какие адреса на встречном конце - ситуация сама по себе прикольная - интерфейс есть, а маршрута через него нет😊 И ниче с этим сделать нельзя - интерфейс динамический - берет настройки с virtual-template, ip с лупбэка через unnumbered - тоесть никак в конфигурации маршрут через него указать нельзя, как и адреса на другом конце😊 Можно настроить xauth и раздавать адреа из пула, но у меня там BGP и нужен статический IP, а создавать пул из 1 адреса тоже как то не красиво😊 Хрен его знает каким образом это работает между кошками но судя по howto и примерам в интернете как то работает. Я нашол только одно упоминание что такая проблема между кошками имеет место быть, и там же нашол решение - запустить до кучи какойнить мульткастовый routing протокол на интерфейсе, конкретно там был rip, но не нравица мне он и я попробовал ospf - и прокатило😊 По ospf кошка быстро снюхалась с жунипером и выяснила какой адрес на другом конце тоннеля, после чего уже стало возможным поднять BGP😊 но это просто на словах, а по факту есть куча ньюансов😊

Первый это собсно вообще наличие ospf на данном участке - учитывая что тоннель домой, роутер домашний и посему как правило на нем есть дефолт, и на бэкбоне есть дефолт😊 и вдобавок да малоли что я там наконфигурю из сетей, и учитывая что ospf фильтрации можно сказать не поддается - нада как то это изолировать от бэкбона, в котором тоже собсно ospf, а бэкбон изолировать от этого участка, ибо если я проанонсирую случайно дефлот в бэкбон из дома это будет ни что иное как пиздец😊 Благо решение нашлось и быстро.

cisco может имеить кучу ospf процессов, причем не связанных друг с другом, посему делаем так - для туннельного интерфейса отдельный ospf процесс, с distance 210, и все - его задача только выяснить что на другом конце тоннеля, ну и до кучи проанонсировать свою сторону но жуниперу это не нужно - там можно статически написать как локальный так и удаленный ip на туннельном интерфейсе, но малоли - может кому еще понадобица.

Тем не менее нам нада как то обмениваца маршрутами с маршрутизаторами входящими в бэкбон. Так как по ospf нельзя ибо как написано выше опастно делать мы это будем по протоколу BGP ибо фильтруеца он как угодно, а на кошке будем делать двухстороннюю редистрибьюцию bgw<->ospf 1.

Juniper как циско иметь кучу независимых ospf процессов не может, зато может по другому - там есть виртуальные роутеры - чтото типа кошкиных VRF тока круче😊 И ospf можно засунуть в такой виртуальный роутер дабы он не анонсировал что ни попадя, и че бы он там ни принял эти анонсы в этом виртуальном роутере так и остануца и не попадут в глобальную таблицу маршрутизации.

Вроде бы на этом все мои страдания по скрещиванию законьчилис, теперь собственно

version 12.4 service nagle no service pad service tcp-keepalives-in service tcp-keepalives-out service timestamps debug datetime msec localtime service timestamps log datetime msec localtime service password-encryption service sequence-numbers no service dhcp ! hostname frontdoor-vpn ! boot-start-marker boot-end-marker ! logging userinfo logging buffered 8192 debugging logging rate-limit 100 except warnings no logging monitor enable secret 5 хервам enable password 7 херасдваопять ! no aaa new-model clock timezone MSK 3 no ip source-route ip arp proxy disable no ip gratuitous-arps ip icmp rate-limit unreachable 1000 ip icmp rate-limit unreachable DF 100 ip cef ! ! ! ! ip vrf backbone rd 42916:1 ! no ip bootp server ip domain timeout 1 ip name-server 91.193.236.3 ip auth-proxy max-nodata-conns 3 ip admission max-nodata-conns 3 login on-failure log ! ! ! ! ! ! ! ! ! ! ! ! ! ! ! ! ! ip tcp ecn ip tcp selective-ack ip tcp synwait-time 10 ip tcp path-mtu-discovery ! crypto keyring DVTI-KEYRING local-address FastEthernet0/0 pre-shared-key address 0.0.0.0 0.0.0.0 key херасдвавамтрианесеркерткей crypto logging session ! crypto isakmp policy 10 encr aes authentication pre-share ! crypto isakmp policy 20 hash md5 authentication pre-share ! crypto isakmp policy 30 authentication pre-share crypto isakmp invalid-spi-recovery crypto isakmp keepalive 20 periodic crypto isakmp profile DVTI-ISAKMP-PROF keyring DVTI-KEYRING match identity address 0.0.0.0 virtual-template 1 ! crypto ipsec security-association replay disable ! crypto ipsec transform-set ESP-DES-SHA esp-des esp-sha-hmac crypto ipsec transform-set ESP-DES-MD5 esp-des esp-md5-hmac crypto ipsec transform-set ESP-AES-SHA esp-aes esp-sha-hmac crypto ipsec transform-set ESP-NULL-MD5 esp-null esp-md5-hmac crypto ipsec transform-set ESP-NULL-SHA esp-null esp-sha-hmac crypto ipsec transform-set ESP-DES esp-des crypto ipsec fragmentation after-encryption ! crypto ipsec profile IPSEC-PROF set transform-set ESP-DES-MD5 ESP-DES-SHA ESP-AES-SHA ESP-NULL-SHA ESP-NULL-MD5 ESP-DES set isakmp-profile DVTI-ISAKMP-PROF ! ! buffers tune automatic ! ! ! interface Loopback0 ip vrf forwarding backbone ip address 100.64.6.1 255.255.255.224 ! interface FastEthernet0/0 ip address 91.193.236.27 255.255.255.248 duplex auto speed auto no mop enabled hold-queue 512 in ! interface FastEthernet0/1 ip vrf forwarding backbone ip address 91.195.204.250 255.255.255.128 ip verify unicast source reachable-via rx ip ospf 1 area 0.0.0.0 duplex auto speed auto no mop enabled hold-queue 512 in ! interface Virtual-Template1 type tunnel ip vrf forwarding backbone ip unnumbered Loopback0 ip mtu 1492 ip tcp adjust-mss 1328 ip ospf network point-to-point ip ospf 2 area 0.0.0.0 tunnel source FastEthernet0/0 tunnel mode ipsec ipv4 tunnel protection ipsec profile IPSEC-PROF hold-queue 256 out ! router ospf 2 vrf backbone router-id 100.64.6.1 log-adjacency-changes passive-interface default no passive-interface Virtual-Template1 distance 210 ! router ospf 1 vrf backbone router-id 91.195.204.250 log-adjacency-changes redistribute connected subnets redistribute bgp 42916 subnets passive-interface default no passive-interface FastEthernet0/1 ! router bgp 42916 bgp router-id 91.193.236.27 bgp log-neighbor-changes neighbor 91.193.236.25 remote-as 42916 neighbor 91.193.236.25 description uplink_to_bgw0 neighbor 91.193.236.30 remote-as 42916 neighbor 91.193.236.30 description uplink_to_bgw1 maximum-paths ibgp 2 ! address-family ipv4 redistribute connected neighbor 91.193.236.25 activate neighbor 91.193.236.25 maximum-prefix 32 50 restart 1 neighbor 91.193.236.30 activate neighbor 91.193.236.30 maximum-prefix 32 50 restart 1 maximum-paths ibgp 2 no auto-summary no synchronization exit-address-family ! address-family ipv4 vrf backbone redistribute connected redistribute ospf 1 vrf backbone match internal external 1 external 2 nssa-external 1 nssa-external 2 neighbor 100.64.6.2 remote-as 42916 neighbor 100.64.6.2 transport connection-mode passive neighbor 100.64.6.2 update-source Loopback0 neighbor 100.64.6.2 activate neighbor 100.64.6.2 next-hop-self neighbor 100.64.6.2 prefix-list no-default-route in neighbor 100.64.6.2 prefix-list no-default-route out neighbor 100.64.6.2 route-map vpn_bgp_out out neighbor 100.64.6.2 maximum-prefix 32 16 restart 10 no synchronization bgp redistribute-internal exit-address-family ! no ip forward-protocol nd no ip forward-protocol udp nameserver no ip forward-protocol udp domain no ip forward-protocol udp time no ip forward-protocol udp netbios-ns no ip forward-protocol udp netbios-dgm no ip forward-protocol udp tacacs ! ! no ip http server no ip http secure-server ! ip access-list standard REMOTE-CONSOLE permit 10.32.75.177 permit 91.193.236.32 0.0.0.31 ! ! ip prefix-list no-default-route seq 5 permit 0.0.0.0/0 ge 1 logging filter flash:logfilter.tcl ! route-map vpn_bgp_out permit 10 set origin igp ! ! ! control-plane ! ! ! ! ! ! ! ! ! ! line con 0 line aux 0 line vty 0 4 access-class REMOTE-CONSOLE in vrf-also exec-timeout 35791 0 password 7 даскокажтутапаролейтоблять:) login transport input all ! process cpu statistics limit entry-percentage 30 size 600 ntp clock-period 17180646 ntp server 91.193.236.10 ntp server 91.193.237.1 ! end

Впринципе тут все понятно - vrf backbone это собственно vrf воткнутый в бэкбон через FastEthernet0/1, на нем поднят ospf процесс номер 1 по которому и происходит обмен маршрутами с маршрутизаторами входящими в бэкбон.

Интернет в глобале по BGP с двух бордеров, через FastEthernet0/0, Он собсно и на бэкбоне есть но сделано так потому что в случае какой либо аварии пока жив хоть один бордер и комутаторы на аплинках интернет будет работать и тоннель соотвественно тоже, и я смогу попасть в сеть на работе. В этом и весь смысл Front Door VPN.

дальше чуть подробней по части самого ipsec:

crypto keyring DVTI-KEYRING local-address FastEthernet0/0 pre-shared-key address 0.0.0.0 0.0.0.0 key херасдвавамтрианесеркерткей

Авторизация и обмен ключами - слушать IKE на интерфейсе FastEthernet0/0 который смотрит на бордеры, ну и авторизация по pre shared key - "херасдвавамтрианесеркерткей" по сути чтото вроде пароля - должен быть одинаковым с ообоих сторон, вместо 0.0.0.0 0.0.0.0 можно задать адрес/подсеть для которых этот pre shared key будет применяца, ну а с нулями будет один на всех.

crypto isakmp policy 10 encr aes authentication pre-share ! crypto isakmp policy 20 hash md5 authentication pre-share ! crypto isakmp policy 30 authentication pre-share

Политики шифрования и хеширования для phase 1 ipsec, применяюца последовательно пока чтото не найдеца чтото общее с удаленной стороной. Я в итоге шифрование отключил вообще, отключил бы и хеширование но нельзя, по стандарту если отключено и то и то то включается и то и то что то там по дефолту😊 но это все лучше чем и то и то учитывая что на этой 3724 криптоакселератора нет и даже без шифрования с md5 хешированием она выдает всего мегабит 20 при этом гордо стоя колом/раком - проц в полку и на консоль отвечает с задержкой секунд в 10😊 но нада отдать должное - ни bgp ни ospf при этом не валяца как я ее не мучал😊 Впринципе дело даже не в мегабитах а в задержках - моя работа сводица практически к ssh терминалам 99% - для этого и 1 мегабита достаточно, а вот задержки чем меньше тем лучше, так вот с шифрованием задержки были порядка 6 ms, с отключенным 1.5-2 ms. С aes было еще хуже. Ну и вдобавок у меня по этому тоннелю еще и голос ходит на рабочий телефон дома, впринципе ему эти 6 мс тоже долампочи но почему бы не сократить если можно😊

crypto isakmp profile DVTI-ISAKMP-PROF keyring DVTI-KEYRING match identity address 0.0.0.0 virtual-template 1

Собсно IKE профиль, применяеца потом в итоге в IPSEC профиле, который в свою очередь применяется уже к интерфейсу, самое значимое тут для нас это virtual-template 1 - номер virtual-template интерфейса с которого клонируются настройки реального интерфейса когда соединение установица.

crypto ipsec security-association replay disable

отключаем защиту от replay атак - лишняя нагрузка на процессор - пусть атакуют я всеравно там ниче не шифрую😊

crypto ipsec transform-set ESP-DES-SHA esp-des esp-sha-hmac crypto ipsec transform-set ESP-DES-MD5 esp-des esp-md5-hmac crypto ipsec transform-set ESP-AES-SHA esp-aes esp-sha-hmac crypto ipsec transform-set ESP-NULL-MD5 esp-null esp-md5-hmac crypto ipsec transform-set ESP-NULL-SHA esp-null esp-sha-hmac crypto ipsec transform-set ESP-DES esp-des

Так называемый у кошки transform-set, по сути набор алгоритмов которыми можно шифровать/хешировать траффик, по сути это уже phase 2 ипсека, тут просто то что сложилось в ходе экспериментов😊

crypto ipsec profile IPSEC-PROF set transform-set ESP-DES-MD5 ESP-DES-SHA ESP-AES-SHA ESP-NULL-SHA ESP-NULL-MD5 ESP-DES set isakmp-profile DVTI-ISAKMP-PROF

ipsec профиль - обьединяет pase 1 и pase 2 в одну кучу, и применяется потом уже на virtual-template интерфейсе.

interface Loopback0 ip vrf forwarding backbone ip address 100.64.6.1 255.255.255.224

Петлевой интерфейс - используется в качестве unnumbered на virtula-template и соотвественно на туннельном тоже, поэтому он в vrf backbone, адреса на другом конце туннеля следует брать из этого диапазона.

interface Virtual-Template1 type tunnel ip vrf forwarding backbone ip unnumbered Loopback0 ip mtu 1492 ip tcp adjust-mss 1328 ip ospf network point-to-point ip ospf 2 area 0.0.0.0 tunnel source FastEthernet0/0 tunnel mode ipsec ipv4 tunnel protection ipsec profile IPSEC-PROF hold-queue 256 out

Virtual-template для туннельных интерфейсов, тут собственно применяется ipsec профиль который IPSEC-PROF, так же прописан ospf процесс 2 с area 0 для выяснения адресов на удаленной стороне тоннеля, сам интерфейс в vrf backbone тоже, ну ip unnumbered с петлевого интерфейса, и самое интересное - ip mtu 1492 и ip tcp adjust-mss 1328, их задача убрать фрагментацию, ipsec вносит оверхед, mtu 1492 потому что дома у меня pppoe до провайдера, ip tcp adjust-mss 1328 потому что оно точно пролезит в mtu 1492 и еще потому что я гдето нарыл умную статью по поводу ipsec performance в которой было опытным путем доказано и теоретически обосновано почему 1328 наиболее оптимально в случае ipsec не смотря на то что оно чуть меньше чем можно было бы сделать, если без подробностей то там еще играет роль выравниевание пакета по границам, и 1328 в этом плане золотая середина😊

router ospf 2 vrf backbone router-id 100.64.6.1 log-adjacency-changes passive-interface default no passive-interface Virtual-Template1 distance 210 ! router ospf 1 vrf backbone router-id 91.195.204.250 log-adjacency-changes redistribute connected subnets redistribute bgp 42916 subnets passive-interface default no passive-interface FastEthernet0/1

OSPF процессы - первый работает на туннельных интерфейсах, второй в бэкбоне, redistribute bgp 42916 subnets - какрас редистрибьюция из bgp в ospf, 42916 процесс BGP по номеру автономной системы как это принято. distance 210 в ospf 2 еще одна предосторожность - даже если мы чето всосем и это пересечется с тем что уже есть маршрут не будет замещен потому что distance больше чем у остальных протоколов.

router bgp 42916 bgp router-id 91.193.236.27 bgp log-neighbor-changes neighbor 91.193.236.25 remote-as 42916 neighbor 91.193.236.25 description uplink_to_bgw0 neighbor 91.193.236.30 remote-as 42916 neighbor 91.193.236.30 description uplink_to_bgw1 maximum-paths ibgp 2 ! address-family ipv4 redistribute connected neighbor 91.193.236.25 activate neighbor 91.193.236.25 maximum-prefix 32 50 restart 1 neighbor 91.193.236.30 activate neighbor 91.193.236.30 maximum-prefix 32 50 restart 1 maximum-paths ibgp 2 no auto-summary no synchronization exit-address-family ! address-family ipv4 vrf backbone redistribute connected redistribute ospf 1 vrf backbone match internal external 1 external 2 nssa-external 1 nssa-external 2 neighbor 100.64.6.2 remote-as 42916 neighbor 100.64.6.2 transport connection-mode passive neighbor 100.64.6.2 update-source Loopback0 neighbor 100.64.6.2 activate neighbor 100.64.6.2 next-hop-self neighbor 100.64.6.2 prefix-list no-default-route in neighbor 100.64.6.2 prefix-list no-default-route out neighbor 100.64.6.2 route-map vpn_bgp_out out neighbor 100.64.6.2 maximum-prefix 32 16 restart 10 no synchronization bgp redistribute-internal exit-address-family

BGP часть, 2 сессии к бордерам в глобале - 91.193.236.25 и 91.193.236.30, от них принимаем дефолт, анонсировать ниче не нада так как directly connected и маршруты до нас на них итак есть.

А под address-family ipv4 vrf backbone собственно конфигурация сессии с juniper.

ip prefix-list no-default-route seq 5 permit 0.0.0.0/0 ge 1 ! route-map vpn_bgp_out permit 10 set origin igp !

Ну собсно route-map меняющий origin и префикс-лист описанные выше.

С кошкой вроде все, дальше juniper кусками, ибо у меня там накручено помимо этого еще дохрена чего и все целиком портянка та еще и слишком будет лишним перегружено.

root@J> show configuration interfaces

st0 {

no-traps;

unit 0 {

description IPSEC-VPN_to_AS42916;

family inet {

mtu 1492;

address 100.64.6.2/32 {

destination 100.64.6.1;

}

}

}

}

Это собственно туннельный интерфейс, mtu такой же как с другой стороны, хоть juniper и не рекомендует его менять, а вместо этого крутить mss тем не менее причин для этого не вижу, вдобавок если мту не совпадет то ospf со стороны кошки не поднимеца пока ей не сказать игнорировать сей факт, а у джунипера там иту по дефолту аж 9k, так что учитывая отсутствие внятного обьяснения причин рекомендации не менять со стороны juniper у меня будет так. Так же нет внятного обьяснения ПОЧЕМУ БЛЯТЬ на туннельном интерфейсе отсутствует reverce path filtering как класс? на других есть тут нет - забыли чтоли😊 junos bla bla lba... extensive continuous testing bla bla lba... ага... пиздатая лапша доширак😊

root@J> show configuration routing-options

static {

route 91.193.236.27/32 {

next-hop pp0.0;

no-readvertise;

}

route 172.16.0.0/12 {

discard;

no-readvertise;

}

route 10.0.0.0/8 {

discard;

no-readvertise;

}

route 100.64.0.0/10 {

discard;

no-readvertise;

}

route 169.254.0.0/16 {

discard;

no-readvertise;

}

route 192.168.0.0/16 {

discard;

no-readvertise;

}

route 0.0.0.0/0 next-hop pp0.0;

}

router-id 100.64.5.5;

forwarding-table {

no-indirect-next-hop;

}

instance-import import-from-inst-AS42916-VPN;

root@J> show configuration protocols bgp

traceoptions {

file bgp.log size 4m files 4;

}

hold-time 180;

no-advertise-peer-as;

mtu-discovery;

log-updown;

local-as 42916;

group iBGP {

type internal;

description "AS internal peers";

neighbor 100.64.6.1 {

description "IPSEC VPN to AS42916 on work";

import [ default-route-reject nexthop-peer ];

export [ default-route-reject reject-uplink nexthop-self redistribute-directly-connected redistribute-ospf ];

peer-as 42916;

}

}

BGP в сторону кошки - тут впринципе все стандартно, ну разьве что не обращайте внимания на redistribute-ospf - как я говорил выше у меня там много чего еще, в том числе и оспф никак не связанный с этой кошкой и тоннелем. hold-time я подкрутил до кошкиного значения. Тем не менее так скажем - идеология настройки BGP у juniper немного другая нежели у cisco, и на мой взгляд лучше, тем что на корню отсекает распиздяйство😊 тут нельзя просто взять и влепить пир - нада создать группу, указать тип группы - iBGP/eBGP, и уже только в группе можно сконфигурировать пир, на cisco тоже так можно, и я к этому и пришол со временем, еще за долго до знакомства с junos вообще, ибо на тех же бордерах где куча пиров конфигурация превращаеца в длиннющую портянку, что:

Вот только на циске можно != обязан, поэтому нужна некоторая дисциплина чтоп не допускать такого, а тут хош не хош а придется.

root@J> show configuration policy-options

policy-statement default-route-reject {

from {

route-filter 0.0.0.0/0 exact;

}

then reject;

}

policy-statement import-from-inst-AS42916-VPN {

term instance {

from instance AS42916-VPN;

}

term local {

from protocol local;

then accept;

}

term direct {

from protocol direct;

then accept;

}

then reject;

}

policy-statement nexthop-peer {

then {

next-hop peer-address;

}

}

policy-statement nexthop-self {

then {

next-hop self;

}

}

policy-statement redistribute-directly-connected {

term direct {

from protocol direct;

then accept;

}

term local {

from protocol local;

then accept;

}

}

policy-statement redistribute-ospf {

term ospf {

from protocol ospf;

then accept;

}

}

policy-statement reject-uplink {

term to_pp0.0 {

to interface pp0.0;

then reject;

}

term from_pp0.0 {

from interface pp0.0;

then reject;

}

}

Собственно политики фильтрации анонсов, а так же импорта маршрутов с виртуального роутера. Разжовывать тут вобщем то нефиг - итак все понятно, ну и все есть в документации если че.

root@J> show configuration security ike

respond-bad-spi 5;

proposal AS42916_IKE-PROPOSAL {

authentication-method pre-shared-keys;

dh-group group1;

authentication-algorithm md5;

encryption-algorithm des-cbc;

lifetime-seconds 86400;

}

policy AS42916_IKE-POLICY {

mode main;

proposals AS42916_IKE-PROPOSAL;

pre-shared-key ascii-text "херасдвавамтрианесеркерткей"; ## SECRET-DATA

}

gateway AS42916-BACKBONE_IKE_GW {

ike-policy AS42916_IKE-POLICY;

address 91.193.236.27;

dead-peer-detection {

interval 10;

threshold 2;

}

nat-keepalive 20;

local-identity inet 100.64.6.2;

external-interface pp0;

}

root@J> show configuration security ipsec

vpn-monitor-options {

interval 60;

threshold 3;

}

proposal AS42916_IPSEC-PROPOSAL {

protocol esp;

authentication-algorithm hmac-md5-96;

}

policy AS42916_IPSEC-POLICY {

perfect-forward-secrecy {

keys group1;

}

proposals AS42916_IPSEC-PROPOSAL;

}

vpn AS42916-BACKBONE {

bind-interface st0.0;

df-bit copy;

vpn-monitor {

optimized;

destination-ip 100.64.5.1;

}

ike {

gateway AS42916-BACKBONE_IKE_GW;

no-anti-replay;

ipsec-policy AS42916_IPSEC-POLICY;

}

establish-tunnels immediately;

}

Весь IPSEC - phase 1 и 2 в одном флаконе😊 Тоже особо разжовывать нечего - 91.193.236.27 адрес кошки с которой пытаемся поднять тоннель, st0.0 - тунельный интерфейс описанный выше, establish-tunnels immediately - поднять тоннель сразу не дожидаясь траффика через него - ибо мы и не дождемся туда никакова траффика без маршрутизации по bgp, н разьве что сам bgp туда начнет ломица дабы поднять сессию, но и то не факт если интерфейс в дауне. и как я уже говорил я убрал шифрование, делается это убиранием encryption-algorithm из proposal AS42916_IPSEC-PROPOSAL... неожиданно😊 ну и плюс настроены dead peer detection и vpn монитор. Так же здесь ньюанс касательно фрагментации опять таки - в vpn AS42916-BACKBONE df-bit copy; - копирует dont fragment бит из нешифрованного пакета в уже шифрованный и инкапсулированный, и если тот потом не лезит в mtu шлет icmp источнику пакета с намеком что нужно пакет помельче😊 А по дефолту он сам их начинает нарезать и фрагментировать, а df срезает, тоесть при таком раскладе pmtu discovery работать не будет, да и производительность страдает, поэтому делаем так.

root@J> show configuration security flow

route-change-timeout 60;

tcp-mss {

all-tcp {

mss 1452;

}

ipsec-vpn {

mss 1328;

}

}

Аналог кошкиного ip tcp adjust-mss, тоесть на стадии tcp хэндшейка правит MSS в пакете, тут у жунипера тоже другая идеология, и на мой взгляд малость ебнутая на всю сука башку по сравнению с кошкой - нельзя выставить эту хрень для интерфейса - можно только для всех - то что all-tcp, и для ipsec - то что в ipsec-vpn, а то что у меня там еще 16 гигабитных интерфейсов с нормальным мту в 1500 или с junbo frame в 9000 с 6 подсетями их неебет ниразу - сказали всем 1452 - значит 1452 блять. Я блять канешна понимаю что можно отмазаца сказав это блять ZBF а не роутер, на что скажу я вам ПНХ!!! - по джуниперовской диаграмке прохождения пакета через сей девайс в flow режиме маршрутизация происходит ДО создания сессии, так что mss с интерфейса выхватить можно, да и если его передернуть в packet mode то это сука роутер, чистокровный блять не подкопаешся, более того тока таким он и был до версии junos 9.четотам, пока туда не начали вкорячивать функционал screenos, а с MPLS он и по сей день может работать только в packet-mode, видать при портировании чето пошло не так, возможно отсутствие MPLS в screenos как класса😊 ЧЕМ ДУМАЛИ хуйзнает вобщем.

ладна возвращаясь к значениям - all-tcp mss 1452 потому что как уже говорил - к провайдеру у меня pppoe, у которого mtu 1492, mss соответственно за вычетом ip заголовков получается 1452. ну а про mss для ipsec я уже писал когда комментировал конфигурацию кошки.

root@J> show configuration routing-instances

AS42916-VPN {

instance-type no-forwarding;

interface st0.0;

routing-options {

router-id 100.64.6.2;

}

protocols {

ospf {

export redistribute-directly-connected;

area 0.0.0.0 {

interface st0.0;

}

}

}

}

А это тот самый виртуальный роутер с ospf в сторону кошки. особо разжовывать вобщем то нечего, делаете виртуальный роутер, instance-type no-forwarding потому что роутить мы там ниче не будим, нам нада просто изолировать ospf процесс, засовываете в него туннельный интерфейс который st0.0, ospf как обычно, и экспортируете потом оттуда directly connected маршруты в основную таблицу, иначе не будет работать маршрутизауия через st0.0 в основном таблице так как его там не будет, и вобщем то все. Надо заметить значительно элегантней, проще и понятнее чем чрезжопный route-leaking между vrf'ами ака кусками MPLS'а притянутого зауши в кошках.

Зоны и межзоновые политики расписывать не буду - итак примеров милион, вдобавок пока вы это не сделаете никакой ipsec вас волновать не будет все равно😊 единственное что для ipsec в зоне с внешним интерфейсом необходимо разрешить сервис ike а в зоне с st0.0 протоколы ospf и bgp, иначе не взлетят ipsec/ospf/bgp, примерно так:

root@J> show configuration security zones

security-zone untrust {

screen untrust-screen;

host-inbound-traffic {

system-services {

ike;

}

}

interfaces {

pp0.0;

ge-0/0/3.0;

}

}

security-zone AS42916-VPN {

screen vpn-screen;

host-inbound-traffic {

system-services {

ping;

traceroute;

}

protocols {

ospf;

bgp;

}

}

interfaces {

st0.0;

}

}

позырить ассоциации:

frontdoor-vpn#show crypto isakmp sa detail

Codes: C - IKE configuration mode, D - Dead Peer Detection

K - Keepalives, N - NAT-traversal

X - IKE Extended Authentication

psk - Preshared key, rsig - RSA signature

renc - RSA encryption

C-id Local Remote I-VRF Status Encr Hash Auth DH Lifetime Cap.

25 91.193.236.27 217.170.124.98 ACTIVE des md5 psk 1 14:40:59 DN

Connection-id:Engine-id = 25:1(software)

24 91.193.236.27 217.170.124.98 ACTIVE des md5 psk 1 13:51:59 DN

Connection-id:Engine-id = 24:1(software)

frontdoor-vpn#

это phase 1

frontdoor-vpn#show crypto session detail

Crypto session current status

Code: C - IKE Configuration mode, D - Dead Peer Detection

K - Keepalives, N - NAT-traversal, X - IKE Extended Authentication

Interface: Virtual-Access3

Session status: UP-ACTIVE

Peer: 217.170.124.98 port 4500 fvrf: (none) ivrf: (none)

Phase1_id: 100.64.6.2

Desc: (none)

IKE SA: local 91.193.236.27/4500 remote 217.170.124.98/4500 Active

Capabilities:DN connid:25 lifetime:14:40:18

IKE SA: local 91.193.236.27/4500 remote 217.170.124.98/4500 Active

Capabilities:DN connid:24 lifetime:13:51:19

IPSEC FLOW: permit ip 0.0.0.0/0.0.0.0 0.0.0.0/0.0.0.0

Active SAs: 2, origin: crypto map

Inbound: #pkts dec'ed 7205856 drop 888 life (KB/Sec) 4505494/2776

Outbound: #pkts enc'ed 5749529 drop 0 life (KB/Sec) 4511285/2776

frontdoor-vpn#

это phase 2

обе можно без detail.

show log kmd, если мало то выткаем trace options в security ike/ipsec, по другому никак.

root@J> show security ike security-associations detail IKE peer 91.193.236.27, Index 8220970, Role: Responder, State: UP Initiator cookie: b0a109742b07d571, Responder cookie: 082e78874ec9c94a Exchange type: Main, Authentication method: Pre-shared-keys Local: 10.245.255.2:4500, Remote: 91.193.236.27:4500 Lifetime: Expires in 49543 seconds Peer ike-id: 91.193.236.27 Xauth assigned IP: 0.0.0.0 Algorithms: Authentication : md5 Encryption : des-cbc Pseudo random function: hmac-md5 Traffic statistics: Input bytes : 1368 Output bytes : 552 Input packets: 15 Output packets: 3 Flags: Caller notification sent IPSec security associations: 0 created, 12 deleted Phase 2 negotiations in progress: 0 IKE peer 91.193.236.27, Index 8220971, Role: Initiator, State: UP Initiator cookie: f187e6faaf5a084d, Responder cookie: d1a9b4a8057f4c27 Exchange type: Main, Authentication method: Pre-shared-keys Local: 10.245.255.2:4500, Remote: 91.193.236.27:4500 Lifetime: Expires in 52483 seconds Peer ike-id: 91.193.236.27 Xauth assigned IP: 0.0.0.0 Algorithms: Authentication : md5 Encryption : des-cbc Pseudo random function: hmac-md5 Traffic statistics: Input bytes : 3940 Output bytes : 4784 Input packets: 15 Output packets: 27 Flags: Caller notification sent IPSec security associations: 12 created, 0 deleted Phase 2 negotiations in progress: 0 root@J>

посмотреть phase 1.

root@J> show security ipsec security-associations detail

Virtual-system: root

Local Gateway: 10.245.255.2, Remote Gateway: 91.193.236.27

Local Identity: ipv4_subnet(any:0,[0..7]=0.0.0.0/0)

Remote Identity: ipv4_subnet(any:0,[0..7]=0.0.0.0/0)

DF-bit: copy

Direction: inbound, SPI: 9bef1366, AUX-SPI: 0

, VPN Monitoring: UP

Hard lifetime: Expires in 2405 seconds

Lifesize Remaining: 4598873 kilobytes

Soft lifetime: Expires in 1790 seconds

Mode: tunnel, Type: dynamic, State: installed

Protocol: ESP, Authentication: hmac-md5-96, Encryption: None

Anti-replay service: disabled

Direction: outbound, SPI: 1cbddc78, AUX-SPI: 0

, VPN Monitoring: UP

Hard lifetime: Expires in 2405 seconds

Lifesize Remaining: 4598873 kilobytes

Soft lifetime: Expires in 1790 seconds

Mode: tunnel, Type: dynamic, State: installed

Protocol: ESP, Authentication: hmac-md5-96, Encryption: None

Anti-replay service: disabled

root@J>

посмотреть phase 2.

Итак пока я сыграв в русскую рулетку с каким то долбаебом на шоссере вывихнул себе правое плече и получил трещину в ребре благодаря чему появилось время продолжить написание данной писанинки продолжим😊

Cвязка squid + c-icap с моими любимыми шлюхами и блэкджеками (ака контент фильтрация) для себя любимого у меня стояла уже лет 10 как в качестве банерорезки и кеша, После начала позора роскомнадзора со своими блокировками я добавил в эту схему tor для обхода блокировок, и i2pd до кучи - хз зачем но пускай будет. Но я все время искал чем бы заменить сквид с его sslbump ибо для одного юзверя это даже не из пушки по воробьям а чето ближе к ядерной боеголовке. И не особо то находил, а без sslbump все это не имеет смысла, большая часть траффика идет по https, и его необходимо расковыривать для фильтрации баннеров и кеширования тоже. Плюс сквид это тот еще монстр и часто заточить его на чтото что вызывает standart violation без рашпиля (ковыряния в исходниках) бывает невозможно. Не для персонального использования он создан, он может не чхая переварить полгига траффика и тысячи юзверей - я правда проверял - может😊 но при этом иногда заставить его к примеру закешировать чтото что по стандарту кешироваца не должно весьма проблематично.

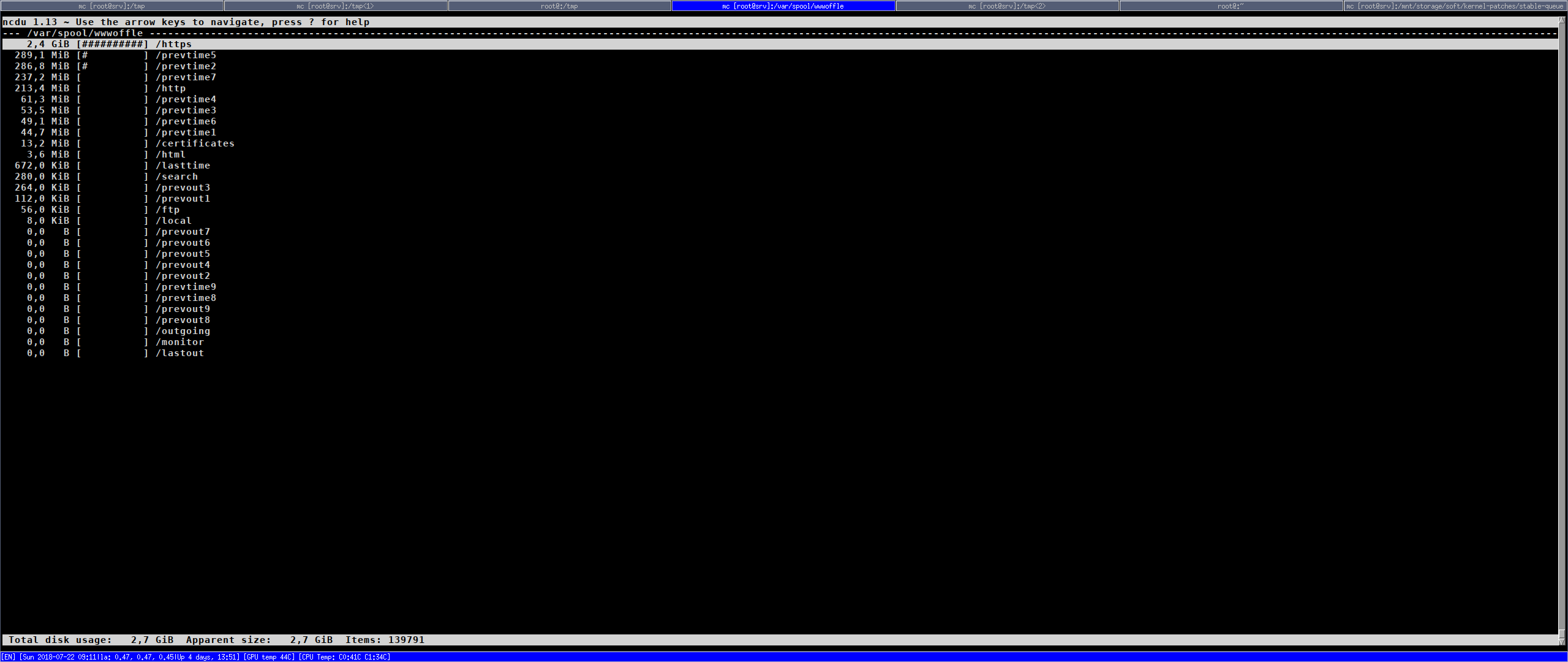

И тут, недавно, не помню уже с чего вдруг гдето выплыл выплыл у меня в поиске [[Glossary_wwwoffle?|wwwoffle]], который заточен какрас для персонального использования в противовес сквиду, и почемуто я решил на него глянуть, не помню уже почему - мошт просто делать нехер было. И полной неожиданностью оказалось что оно умеет mitm ака sslbump в сквиде типа из коропки, причем уже много лет, и кешировать https тоже умеет, ну и еще кучу всяких standart violation для которых squid нада затачивать что не всегда тривиально, а тут типа все есть. ну и сразу же я решил сие дело посмотреть и опробовать.

Вообще так как все это нужно для 1-2-3 добашних клиентов, требования ко всему этому очень просты:

Оно умеет далеко не все что нужно и списка выше. пойдем с конца:

Остальное все умеет, и кое чего сверху по мелочи. И да - оно маленькое и простое, и кривое😊

В gentoo оказалась довольно древняя версия, поэтому засунул на ее основе последнюю с сайта в свой локальный оверлей и благополучно собрал, и вроде бы все зашибись, кроме одного но - вылез какой то raice condition при генерации фейковых сертификатов, каким то образом получалось что одновременно 2 процесса генерируют пару ключ-сертификат для даного сайта, и один заканьчивает раньше другого, в итоге ключь к самому сертификату не подходит и естественно ничего не работает - бида пичаль.

Врубил логгинг на все - по его строкам нашол процедуру которая генерит сертификаты - в src/certificates.c

static gnutls_certificate_credentials_t GetCredentials(const char *hostname,int server)

посмотрел наискосок - вникать не стал - криво оно конечно реализовано ну да ладна - до того я еще успел нагуглить чтото типа форка wwwoffle-par, чувак долго и много чего там дорабатывал, влоб поставил на проверку - raice отсуствует - тупо скопипастил тело процедуры к себе, сделал патчь, пересобрал с оригинальной версией - raice исчез - алилуя - можно пробовать юзать дальше😊

а дальше, наткнулся на SVN, посмотрел что там, и решил подняца до него - хуже не будет, так родился второй патч😊 Попутно портировал фичу session cookies only из ветки -par, так родился третий патч, ну а четвертый мелкий фикс ворнинга - до кучи😊 Нну и пошло-поехало😊

Собсно сами патчи:

На генте все эти патчи можно сложить в

/etc/portage/patches/net-proxy/wwwoffle

и они применяца автоматом при сборке, ЕСЛИ! в ебилде вызов epatch_user в src_prepare(), а есть он блять не везде.. поэтому гдето это работает а гдето нет. Но есть способ сделать чтоп работало всегда и везде.

Вобщем наигравшись с исходниками и добившись какой-никакой но приемлемой работы я принялся играца с конфигурацией😊 Итак:

Собственно конфигурация wwwoffle находица в

/etc/wwwoffle/wwwoffle.conf

Я уже точно не помню что по дефолту а что я менял так что опишу что посчитаю нужным посекционно так как конциоурация у wwwoffle секционная, есть же документация в конце концов😊 итак:

StartUp

{

bind-ipv4 = 127.0.0.1

bind-ipv6 = none

http-port = 3128

https-port = 3129

wwwoffle-port = 8081

spool-dir = /var/spool/wwwoffle

run-uid = wwwoffle

run-gid = wwwoffle

use-syslog = yes

password = none

max-servers = 16

max-fetch-servers = 1

}

Тут ничего особенного - слушаем все порты на локалхосте так как оно лиш для меня любимого, для меня любимого не на локалхосте там сбоку приставлен socks5 через который я и работаю когда не на локалхосте😊

Собственно сам http прокси живет на 3128 порту, там же и https через метод коннект, тоесть в бравзере прописывается localhost:3128 и фтыкаеца галка юзать его для всех протоколов и на этом все.

Options

{

log-level = info

socket-timeout = 120

dns-timeout = 60

connect-timeout = 30

connect-retry = no

dir-perm = 0755

file-perm = 0644

lock-files = yes

reply-compressed-data = no

reply-chunked-data = yes

#exec-cgi = /local/cgi-bin/*

#exec-cgi = /local/*.cgi

}

OnlineOptions

{

<*://*/*.js?*> request-changed = 10m

<*://*/*.css?*> request-changed = 10m

<*://*/*.json> request-changed = 10m

<*://*/*.css> request-changed = 6w

<*://*/*.css> pragma-no-cache = no

<*://*/*.css> cache-control-no-cache = no

<*://*/*.css> cache-control-max-age-0 = no

<*://*/*.css> request-no-cache = no

<*://*/*.js> request-changed = 6w

<*://*/*.js> pragma-no-cache = no

<*://*/*.js> cache-control-no-cache = no

<*://*/*.js> cache-control-max-age-0 = no

<*://*/*.js> request-no-cache = no

<*://*/*.png> request-changed = 6w

<*://*/*.png> pragma-no-cache = no

<*://*/*.png> cache-control-no-cache = no

<*://*/*.png> cache-control-max-age-0 = no

<*://*/*.png> request-no-cache = no

<*://*/*.jpg> request-changed = 6w

<*://*/*.jpg> pragma-no-cache = no

<*://*/*.jpg> cache-control-no-cache = no

<*://*/*.jpg> cache-control-max-age-0 = no

<*://*/*.jpg> request-no-cache = no

<*://*/*.jpeg> request-changed = 6w

<*://*/*.jpeg> pragma-no-cache = no

<*://*/*.jpeg> cache-control-no-cache = no

<*://*/*.jpeg> cache-control-max-age-0 = no

<*://*/*.jpeg> request-no-cache = no

<*://*/*.gif> request-changed = 6w

<*://*/*.gif> pragma-no-cache = no

<*://*/*.gif> cache-control-no-cache = no

<*://*/*.gif> cache-control-max-age-0 = no

<*://*/*.gif> request-no-cache = no

<*://*/*.ico> request-changed = 6w

<*://*/*.ico> pragma-no-cache = no

<*://*/*.ico> cache-control-no-cache = no

<*://*/*.ico> cache-control-max-age-0 = no

<*://*/*.ico> request-no-cache = no

<*://*/*.swf> request-changed = 6w

<*://*/*.swf> pragma-no-cache = no

<*://*/*.swf> cache-control-no-cache = no

<*://*/*.swf> cache-control-max-age-0 = no

<*://*/*.swf> request-no-cache = no

<*://*/*.pdf> request-changed = 6w

pragma-no-cache = yes

cache-control-no-cache = yes

cache-control-max-age-0 = yes

request-changed = 10m

request-changed-once = yes

request-expired = yes

request-no-cache = no

request-redirection = no

request-conditional = yes

validate-with-etag = no

try-without-password = yes

intr-download-keep = no

intr-download-size = 1

intr-download-percent = 80

timeout-download-keep = no

keep-cache-if-not-found = yes

request-compressed-data = yes

request-chunked-data = yes

}

OfflineOptions

{

pragma-no-cache = yes

cache-control-no-cache = yes

cache-control-max-age-0 = yes

confirm-requests = no

# Dont request any URLs at all when offline.

<*://*/*> dont-request = yes

}

Тут только расскоментировал <*:*/*> dont-request = yes - зачем чтото запрашивать в оффлайне?

SSLOptions

{

enable-caching = yes

quick-key-gen = yes

disallow-cache = *.googlevideo.com:443

allow-tunnel = *.googlevideo.com:443

allow-cache = *:443

}

Вотанон - святой грааль - https mitm ака sslbump в сквиде😊

FetchOptions

{

stylesheets = yes

images = yes

frames = yes

iframes = yes

scripts = no

objects = no

webbug-images = no

icon-images = no

only-same-host-images = no

}

Тут не помню - помоему ниче не трогал, но эта секция какрас отвечает за скачивание запроенных страниц в оффлайне или вручную.

IndexOptions

{

create-history-indexes = yes

cycle-indexes-daily = yes

#### Example ####

# Do index files from /good/ in the barfoo.com domain.

# <*://*.barfoo.com/good/*> list-any = yes

# Don't index any hosts in the barfoo.com domain.

# <*://*.barfoo.com> list-any = no

# Don't index any gif or jpg files in the lasttime index.

# <*://*/*.gif> list-latest = no

# <*://*/*.jpg> list-latest = no

}

Так и не понял что это и зачем вообще, ниче не трогал😊

ModifyHTML

{

enable-modify-html = yes

#site specific fixes

<*://srv.lan> disable-meta-set-cookie = no

<*://*.lostfilm.tv/*> disable-meta-refresh = no

<*://*.lostfilm.tv/*> disable-meta-set-cookie = no

<*://*.google.*/recaptcha/*> disable-meta-set-cookie = no

<*://*.gstatic.com/recaptcha/*> disable-meta-set-cookie = no

<*://*.phoronix.com> disable-meta-set-cookie = no

<*://forum.mtbtula.ru> disable-meta-set-cookie = no

<*://forum.nag.ru> disable-meta-set-cookie = no

<*://*.chipdip.ru> disable-meta-set-cookie = no

<*://*.ripe.net> disable-meta-set-cookie = no

#end site specific fixes

add-cache-info = no

#anchor-cached-begin = <font color="#00B000">

#anchor-cached-end = </font>

#anchor-requested-begin = <font color="#B0B000">

#anchor-requested-end = </font>

#anchor-not-cached-begin = <font color="#B00000">

#anchor-not-cached-end = </font>

disable-script = no

disable-applet = no

disable-style = no

disable-blink = no

disable-marquee = no

disable-flash = no

disable-meta-refresh = yes

disable-meta-refresh-self = yes

disable-meta-set-cookie = yes

disable-dontget-links = yes

replace-dontget-images = yes

replacement-dontget-image = /local/dontget/replacement.gif

replace-webbug-images = yes

replacement-webbug-image = /local/dontget/replacement.gif

disable-dontget-iframes = yes

demoronise-ms-chars = no

fix-mixed-cyrillic = no

disable-animated-gif = no

}

Эта секция позволяет делать некоторые манипуляции непосредственно с контентом страницы.

LocalHost

{

localhost

}

Собсно хост на котором крутица wwwoffle😊

LocalNet

{

srv.lan

megaprovider.ru

icf.org.ru

icf.bofh.ru

*.icf.org.ru

*.icf.bofh.ru

}

Локальные сервера, можно с масками как видим. Они не кешируются вообще и считаются всегда доступными, тоесть даже в оффлайн режиме.

AllowedConnectHosts

{

}

Суда можно вписать имена хостов или ip в [] скобках с которых будет доступ к wwwoffle если он нужен не только на локалхосте, мне такого не нужно так что пусто.

AllowedConnectUsers

{

}

Суда можно вписать юзеров с паролями имеющих доступ к wwwoffle, так как я один мне это тоже нах не нада и потому пусто.

DontCache [ dontcache.list ]

А суда можно вписать урлы которые ненада кешировать, или заинклудить файл с ними сменив скобки с {} на [], в таком случае wwwoffle ищет этот файл в той же директории где и конфигурационный, никакие другие пути не поддерживаются.

Содержимое dontcache.list:

# Don't cache any dynamic pages *://*/*/*?* # Don't cache any archive files. *://*/*.gz *://*/*.tar *://*/*.bz *://*/*.bz2 *://*/*.Z *://*/*.zip *://*/*.rar *://*/*.tgz *://*/*.xz *://*/*.rpm *://*/*.deb # Don't cache any video files. *://*/*.webm *://*/*.mp4 *://*/*.avi *://*/*.ts *://*/*.m3u8 *://*/*/video/* *://*/*/videoplayback *://*.googlevideo.com/* # Don't cache any audio files. *://*/*.mp3 *://*/*.ogg *://*/*.m4s #other misc files *://*/*.torrent # other misc sites *://*.adblockplus.org *://easylist.to *://raw.githubusercontent.com/zpacman/Blockzilla/master/* *://addons.palemoon.org

Собсно тут мы запрещаем кешировать динамику, ато до этого у меня набролось куча закешированных урлов вида http://www.google.ru/url?q=http://wiki.icf.org.ru/2018-07-09_Networking-Blog&sa=U&ved=0ahUKEwiG5ffFnbHcAhVGliwKHZTbCIgQFggnMAM&usg=AOvVaw3UIUcZ1F3FUgGUcx2qYU23 благодаря ебучему гуголу которому сцуко нада следить за мною и куда я жму тоже, и по этому он отдает ссылки с поиска тока редиректом, ну и не тока ебучий гугол ебучий гугол, есть еще много других ебучих сайтов делающих примерно так же, в итоге у меня за неделю с небольшим с полгига такого дерьма закешировалось - пришлось запретить😊 Так же запрещаем кешировать всякие архивы, видео, музыку и прочую такую дрочь. Ну и несколько сайтов с которых нада получать свежак всегда, addblock листы в частности и аддоны бравзера.

DontGet [ adblock-list-justdomains.txt adguarddns-justdomains.txt advblock-justdomains.txt adwarefilters-justdomains.txt antiadblockfilters-justdomains.txt bitblockext-justdomains.txt Blockzilla-justdomains.txt cjx-annoyance-justdomains.txt cntblock-justdomains.txt easylistchina-justdomains.txt easyprivacy-justdomains.txt fanboy-annoyance-justdomains.txt malwaredomains_full-justdomains.txt nocoin-justdomains.txt ruadlist+easylist-justdomains.txt dontget.list ]

А вот и секция DontGet со списками что не нужно запрашивать совсем, иначе говоря зарезать. Списки подгружаюца так же из отдельных файликов. Единственный редактируемый вручную файл тут это dontget.list, остальные генеряца автоматически по различным блэклистам.

собсно содержимое dontget.list:

#favicons

*://*/favicon.ico

<*://*/favicon.ico> replacement = /local/dontget/favicon.ico

*://*/favicon.png

<*://*/favicon.png> replacement = /local/dontget/replacement.png

*://*/*favicon*.png

<*://*/*favicon*.png> replacement = /local/dontget/replacement.png

#annoing sheet

*://*/*/twitter.png

*://node.chathelp.ru/*

*://*.apphb.com/signalr/*

*://*.hypercomments.com/*

*://*.google-analytics.com/*

*://accounts.google.com/*

*://*.google.*/complete/search*

*://*.google.*/logos/doodles/*

<*://*.google.*/logos/doodles/*> replacement = /local/dontget/replacement.gif

*://*.googletagservices.com/*

*://*.googletagmanager.com/*

*://*.google.com/ads/measurement*

*://*.google.*/*/generate_204

*://*google.*/*/client_204?*

*://*.google.*/coop/cse/*

#http://yandex.st/share/share.js

*://api.github.com/_private/browser/*

*://api.rnet.plus/*

*://softdatasystemru.webim.ru/*

*://*.digitaltarget.ru/*

*://*.scorecardresearch.com/*

*://service.maxymiser.net/*

*://*.facebook.com/plugins/*

*://*.smartadcheck.de

*://*.reddit.com/*?!POST:*

*://*.redditmedia.com/gtm*

*://*.redditstatic.com/desktop2x/*.js

*://*.mamydirect.com

*://ssp.rambler.ru/acp/*

*://zdstatic.speedtest.net/*/zdconsent.js

*://*.cdnst.net/javascript/prebid.*.min.js

*://*/ajax/setcookie.php?*

*://*/*/cookie_policy.css

*://*/*/cookieconsent.min.css

*://*/*/*.gif?*

*://*/*/*.svg?*

*://*/*/*.png?*

#annoing js

*://*/*/raven.min.js*

*://*/*/raven.js*

*://*/*/adriver.js*

*://*/*/adriver.core.2.js*

*://*/*/ads.js*

*://*/*/gtm.js*

*://*/*/twemoji.min.js*

#AD

*://ad.3dnews.ru/*

*://ad.mail.ru/*

*://ad.trialsport.ru/*

*://ad.velomania.ru/*

*://ads.adfox.ru/*

*://ads.exoclick.com/*

*://ads.servebom.com/*

*://*.ads.claw.ru/*

*://adservice.google.*/*

*://pagead2.googlesyndication.com/*

*://adx.com.ru/*

*://*.doubleclick.net/*

*://cdn.sstatic.net/clc/clc.ie.min.js

*://cdn.sstatic.net/Js/stub.en.js

*://*.opennet.ru/cgi-bin/opennet/hints.cgi*

*://www.opennet.ru/img/*

*://www.opennet.ru/img/ihor_but.png

*://*.linux.org.ru/adv/*

*://*.linux.org.ru/linuxpiter/*

*://dr.habracdn.net/*/advertise.js*

*://dr.habracdn.net/*/highlight.pack.js*

*://special.habrahabr.ru/api/toplink/*

*://cdnjs.cloudflare.com/*/MathJax.js*

*://cdn.onthe.io/io.js*

*://static.criteo.net/js/*

*://*.amazon-adsystem.com/*

*://*.trafficfactory.biz/*

*://*.advertur.ru/*

*://*.acint.net/*

*://seal.alphassl.com/*

*://*.betsonsport.ru/banners/*

*://robinbob.in

*://static.t-ru.org/templates/*/*lib.min.js

*://*.actionteaser.ru/*

*://*.directadvert.ru/*

#COUNTERS

*://*counter*/*

*://x.cnt.my/*

*://cnt.vvv.ru/*

*://server.comagic.ru/comagic/*

*://tracker.comagic.ru/*

*://collector.githubapp.com/*

*://my-hit.org/scripts/js/metrika/metrika.js*

*://rules.quantcount.com/*.js*

*://*/*counter*?*

<*://*/*/*.js> replacement = /local/dontget/replacement.js

<*://*/*/*.png> replacement = /local/dontget/replacement.png

<*://*/*/*.gif> replacement = /local/dontget/replacement.gif

<*://*/*/*.jpg> replacement = /local/dontget/replacement.gif

<*://*/*/*.svg> replacement = /local/dontget/replacement.gif

location-error = no

Это собственно то что я вручную прирезал ибо нехуй😊 Ну вот не понимаю и не принимаю я изьебов с favicon, с generate_204, с автоподсказками в поиске итд.

Остальное генерица вот этой вот штукой - https://github.com/justdomains/ci немного модифицированной, у нее на выхлопе просто списки доменов, нам же нужны маски понимаемые wwwoffle, ну Patch_justdomains.patch патч тривиальный😊

Патченный convertlists.py и lists.json находяца в /etc/wwwoffle/scripts, запускаеца это дело по крону вот так:

BLOCK_LOGFILE="/tmp/adblock.log"

@daily cd /etc/wwwoffle/scripts && /etc/wwwoffle/scripts/convertlists.py -v /etc/wwwoffle/scripts/lists.json /etc/wwwoffle &>>${BLOCK_LOGFILE} && /usr/bin/wwwoffle -config &>>${BLOCK_LOGFILE}

Содержимое lists.json:

[

{

"name": "RUADlist+EasyList",

"url": "https://easylist-downloads.adblockplus.org/ruadlist+easylist.txt",

"format": "adbp",

"moreinformation": "https://easylist.to/",

"description": "EasyList is the primary filter list that removes most adverts from international webpages, including unwanted frames, images and objects. It is the most popular list used by many ad blockers and forms the basis of over a dozen combination and supplementary filter lists.",

"license-identifier": "GPL3 / CC BY-SA 3.0"

},

{

"name": "EasyPrivacy",

"url": "https://easylist.to/easylist/easyprivacy.txt",

"format": "adbp",

"moreinformation": "https://easylist.to/",

"description": "EasyPrivacy is an optional supplementary filter list that completely removes all forms of tracking from the internet, including web bugs, tracking scripts and information collectors, thereby protecting your personal data.",

"license-identifier": "GPL3 / CC BY-SA 3.0"

},

{

"name": "AntiADblock",

"url": "https://easylist-downloads.adblockplus.org/antiadblockfilters.txt",

"format": "adbp",

"moreinformation": "https://easylist.to/",

"description": "EasyPrivacy is an optional supplementary filter list that completely removes all forms of tracking from the internet, including web bugs, tracking scripts and information collectors, thereby protecting your personal data.",

"license-identifier": "GPL3 / CC BY-SA 3.0"

},

{

"name": "ADVblock",

"url": "https://easylist-downloads.adblockplus.org/advblock.txt",

"format": "adbp",

"moreinformation": "https://easylist.to/",

"description": "EasyPrivacy is an optional supplementary filter list that completely removes all forms of tracking from the internet, including web bugs, tracking scripts and information collectors, thereby protecting your personal data.",

"license-identifier": "GPL3 / CC BY-SA 3.0"

},

{

"name": "CNTblock",

"url": "https://easylist-downloads.adblockplus.org/cntblock.txt",

"format": "adbp",

"moreinformation": "https://easylist.to/",

"description": "EasyPrivacy is an optional supplementary filter list that completely removes all forms of tracking from the internet, including web bugs, tracking scripts and information collectors, thereby protecting your personal data.",

"license-identifier": "GPL3 / CC BY-SA 3.0"

},

{

"name": "BITblockext",

"url": "https://easylist-downloads.adblockplus.org/bitblockext.txt",

"format": "adbp",

"moreinformation": "https://easylist.to/",

"description": "EasyPrivacy is an optional supplementary filter list that completely removes all forms of tracking from the internet, including web bugs, tracking scripts and information collectors, thereby protecting your personal data.",

"license-identifier": "GPL3 / CC BY-SA 3.0"

},

{

"name": "FanBoy-Annoyance",

"url": "https://easylist.to/easylist/fanboy-annoyance.txt",

"format": "adbp",

"moreinformation": "https://easylist.to/",

"description": "EasyPrivacy is an optional supplementary filter list that completely removes all forms of tracking from the internet, including web bugs, tracking scripts and information collectors, thereby protecting your personal data.",

"license-identifier": "GPL3 / CC BY-SA 3.0"

},

{

"name": "easylist-china",

"url": "https://easylist-downloads.adblockplus.org/easylistchina.txt",

"format": "adbp",

"moreinformation": "https://adblockplus.org/ru/subscriptions",

"description": "EasyPrivacy is an optional supplementary filter list that completely removes all forms of tracking from the internet, including web bugs, tracking scripts and information collectors, thereby protecting your personal data.",

"license-identifier": "GPL3 / CC BY-SA 3.0"

},

{

"name": "cjx-annoyance",

"url": "https://raw.githubusercontent.com/cjx82630/cjxlist/master/cjx-annoyance.txt",

"format": "adbp",

"moreinformation": "https://adblockplus.org/ru/subscriptions",

"description": "Specialization: removes self-promotion and privacy protection, ÄÏÐÏÌÎÅÎÉÅ Ë EasyList China",

"license-identifier": "GPL3 / CC BY-SA 3.0"

},

{

"name": "Blockzilla",

"url": "https://raw.githubusercontent.com/zpacman/Blockzilla/master/Blockzilla.txt",

"format": "adbp",

"moreinformation": "https://adblockplus.org/ru/subscriptions",

"description": "Specialization: ads and tracking protection, English",

"license-identifier": "GPL3 / CC BY-SA 3.0"

},

{

"name": "adware-filters",

"url": "https://easylist-downloads.adblockplus.org/adwarefilters.txt",

"format": "adbp",

"moreinformation": "https://adblockplus.org/ru/subscriptions",

"description": "Specialization: blocks ads injected by adware",

"license-identifier": "GPL3 / CC BY-SA 3.0"

},

{

"name": "Malware_Domains",

"url": "https://easylist-downloads.adblockplus.org/malwaredomains_full.txt",

"format": "adbp",

"moreinformation": "https://adblockplus.org/ru/subscriptions",

"description": "Specialization: malware protection",

"license-identifier": "GPL3 / CC BY-SA 3.0"

},

{

"name": "spam404",

"url": "https://raw.githubusercontent.com/Dawsey21/Lists/master/adblock-list.txt",

"format": "adbp",

"moreinformation": "https://adblockplus.org/ru/subscriptions",

"description": "Specialization: blocks scam sites",

"license-identifier": "GPL3 / CC BY-SA 3.0"

},

{

"name": "AdGuard Simplified Domain Names Filter",

"url": "https://filters.adtidy.org/extension/chromium/filters/15.txt",

"format": "adbp",

"outputfile": "adguarddns.txt",

"moreinformation": "https://kb.adguard.com/en/general/adguard-ad-filters",

"description": "A filter composed from several other filters (English filter, Social media filter, Spyware filter, Mobile ads filter, EasyList and EasyPrivacy) and simplified specifically to be better compatible with DNS-level ad blocking. This filter is used by AdGuard DNS servers to block ads.",

"license-identifier": "GPL3"

},

{

"name": "NoCoin Filter List",

"url": "https://raw.githubusercontent.com/hoshsadiq/adblock-nocoin-list/master/hosts.txt",

"format": "hosts",

"outputfile": "nocoin.txt",

"moreinformation": "https://github.com/hoshsadiq/adblock-nocoin-list/",

"description": "Blocking Web Browser Bitcoin Mining",

"license-identifier": "MIT",

"license": "https://github.com/hoshsadiq/adblock-nocoin-list/blob/master/LICENSE"

}

]

тоесть по сути подписки управляюца через ists.json, ну и в DontGet не забыть вписать результирующие файлики.

DontCompress

{

mime-type = image/gif

mime-type = image/jpeg

mime-type = image/png

mime-type = image/tiff

mime-type = video/x-msvideo

mime-type = video/quicktime

mime-type = video/mpeg

mime-type = audio/basic

mime-type = audio/x-wav

mime-type = application/x-dvi

mime-type = application/pdf

mime-type = application/zip

mime-type = application/x-ns-proxy-autoconfig

file-ext = .gz

file-ext = .bz

file-ext = .bz2

file-ext = .Z

file-ext = .zip

file-ext = .tgz

file-ext = .rpm

file-ext = .deb

file-ext = .gif

file-ext = .GIF

file-ext = .jpg

file-ext = .JPG

file-ext = .jpeg

file-ext = .JPEG

file-ext = .png

file-ext = .PNG

}

Что ненада сжимать по майм типам или по расширению файла - картинки, архивы, и все такое, помоему вообще тут ничего не правил.

CensorHeader [ censorheader.list ]

Список заголовков которые нада вырезать, или подменить, и еще несколько фич - читайте мануал кароче😊 тут опять инклудица файл censorheader.list.

Содержимое censorheader.list:

referer-self = yes

referer-self-dir = no

referer-from = no

force-user-agent = no

pass-url-unchanged = no

User-Agent = Mozilla/5.0 (X11; Linux x86_64; rv:3.4) Gecko/20100101 Goanna/20180717 PaleMoon/27.9.4

# allow cookies for specific sites

<*://srv.lan> Set-Cookie = no

<*://srv.lan> Cookie = no

<*://srv.lan> session-cookies-only = no

<*://*.lostfilm.tv> Set-Cookie = no

<*://*.lostfilm.tv> Cookie = no

<*://*.lostfilm.tv> session-cookies-only = no

<*://forum.mtbtula.ru> Set-Cookie = no

<*://forum.mtbtula.ru> Cookie = no

<*://forum.mtbtula.ru> session-cookies-only = no

<*://forum.nag.ru> Set-Cookie = no

<*://forum.nag.ru> Cookie = no

<*://forum.nag.ru> session-cookies-only = no

<*://*.chipdip.ru> Set-Cookie = no

<*://*.chipdip.ru> Cookie = no

<*://*.chipdip.ru> session-cookies-only = no

<*://*.google.*/recaptcha/*> Set-Cookie = no

<*://*.google.*/recaptcha/*> Cookie = no

<*://*.google.*/recaptcha/*> session-cookies-only = yes

<*://*.gstatic.com/recaptcha/*> Set-Cookie = no

<*://*.gstatic.com/recaptcha/*> Cookie = no

<*://*.gstatic.com/recaptcha/*> session-cookies-only = yes

<*://*.phoronix.com> Set-Cookie = no

<*://*.phoronix.com> Cookie = no

<*://*.phoronix.com> session-cookies-only = yes

<*://*.ripe.net> Set-Cookie = no

<*://*.ripe.net> Cookie = no

<*://*.ripe.net> session-cookies-only = yes

<*://*.cvedetails.com> Set-Cookie = no

<*://*.cvedetails.com> Cookie = no

<*://*.cvedetails.com> session-cookies-only = yes

# block all cookies

# Set-Cookie = yes

# Cookie = yes

#allow session cookies only

session-cookies-only = yes

# block other annoing headers

# dont block Access-Control-Allow-Origin - used some video hostings

Via = yes

# Strict-Transport-Security = yes

# X-Frontend = yes

# X-Powered-By = yes

# X-Frame-Options = yes

#github

# X-Fastly-Request-ID = yes

# X-Timer = yes

# X-Cache-Hits = yes

# X-Cache = yes

# X-Served-By = yes

# X-GitHub-Request-Id = yes

# X-Geo-Block-List = yes

# X-XSS-Protection = yes

# X-Content-Type-Options = yes

# Content-Security-Policy = yes

# Access-Control-Expose-Headers = yes

тут мы разрешаем куки на нужные мне сайты.

Proxy [ proxy_header blocked_domains_rkn.list blocked_urls_rkn.list proxy_footer ]

А вот и секция парент прокси, именно тут разруливается что через какой вышестоящий прокси запрашивать, а что на прямую - сердце так сказать механизьма обхода блокировок позорного РКН. прокси указываются раздельно для http и https что не совсем удобно.

proxy_header:

# TOR internal resources #<http://*.onion> proxy = localhost:8888 #<https://*.onion> ssl = localhost:8888 # I2P internal resources <http://*.i2p> proxy = localhost:4444 <https://*.i2p> proxy = localhost:4444

Тут мы указываем parent прокси для внутренних ресурсов TOR и I2P сетей. TOR предоставляет только socks прокси в отличии от I2p, поэтому между ним и wwwoffle стоит промежуточный 3proxy, который умеет преобразовывать socks<=>http/s.

proxy_footer:

<*://*/*> proxy = none <*://*/*> ssl = none

Здесь мы запрещаем все прокси для всех, тоесть если адрес не в I2P/TOR сети и не в списках РКН то идем директом, именно поэтому этот файл должен быть последним в секции.

Генерируется это все вот таким нехитрым скриптом лежащим в /etc/wwwoffle/scripts под названием rkn.sh:

#!/bin/bash

PROXY="localhost:8888"

OUT_ENCODING="koi8-r"

LOGFILE="/tmp/rkn.log"

ERDI_XML="/usr/bin/xmlstarlet"

EIPSET="/usr/sbin/ipset"

TMPFILE=`mktemp`

#TMPFILE="/tmp/dump.xml"

wget --retry-connrefused -O $TMPFILE http://api.antizapret.info/all.php?type=xml

create_ipset()

{

"${EIPSET}" flush $2 2>/dev/null || "${EIPSET}" create $2 $1 maxelem 262144

for f in "$3" "$4"

do

[ -f "$f" ] && {

echo Adding to ipset $2 \($1\) : $f

sort -u "$f" | sed -nre "s/^.+$/add $2 &/p" | "${EIPSET}" -! restore

}

done

return 0

}

ACL=/etc/wwwoffle/blocked_domains_rkn.list

echo "Список доменов нормализованный ($ACL)"

mv $ACL $ACL.bak

"${ERDI_XML}" select -E "$OUT_ENCODING" -T -t -v "/reg:register/content/domain" -n "$TMPFILE" \

|sort \

| uniq \

|idn --quiet --no-tld -- \

|awk -v PROXY=$PROXY '/[0-9]|[a-z]/ {print "<http://" $0 "> proxy = "PROXY;print "<https://" $0 "> ssl = "PROXY;}' \

> $ACL

wc -l <$ACL

ACL=/etc/wwwoffle/blocked_urls_rkn.list

echo "Список url адресов ($ACL)"

mv $ACL $ACL.bak

"${ERDI_XML}" select -E "$OUT_ENCODING" -T -t -v "/reg:register/content/url" -n "$TMPFILE" \

|tr -s "\," "\n" \

|grep -e "^http" \

|sort \

|uniq \

|grep -v "<" \

|grep -v ">" \

|awk -v PROXY=$PROXY '$0 ~ /^https:/ {print "<" $0 "> ssl = "PROXY}; $0 ~ /^http:/ {print "<" $0 "> proxy = "PROXY}' \

> $ACL

wc -l <$ACL

ACL=`mktemp`

echo "Список IP адресов ($ACL)"

"${ERDI_XML}" select -E "$OUT_ENCODING" -T -t -v "/reg:register/content/ip" -n "$TMPFILE" \

|tr "\," "\n" \

|sort -V -u \

> $ACL

wc -l <$ACL

create_ipset hash:net blocked_ip_rkn $ACL

rm $ACL

rm $TMPFILE

Слить чтоп не копипастить дохрена:)

Для работы нужен xmlstarlet и ipset, ну wget,awk,grep,sort и остальное как правило есть везде. Список блокировок выкачивается с https://antizapret.info/ через ихний api, но впрочем их куча еще и на гитхабе и где их ща тока нет😊 ipset нужен не для самой wwwofle а для PBR, который нужен потому что по ip и подсетям wwwoffle выбирать выщестоящие прокси не умеет а РКН не вкурсе такой хуйни, и блочит и по ip и подсетями тоже, причем нехилыми такими типа /15, а потом фсе плачут и пиздец, но хуйвам - прорвемся😊 и поэтому чтоп как то обратабывать эти блоки подсетей и ипишников используется ipset + PBR.

Переменную PROXY нада выставить в адрс и порт того самого промежуточного 3proxy.

запускаеца по крону вот так:

RKN_LOGFILE="/tmp/rkn.log"

@reboot /usr/bin/sleep 30 && /etc/wwwoffle/scripts/rkn.sh &>${RKN_LOGFILE} && /usr/bin/wwwoffle -config &>>${RKN_LOGFILE}

@daily /etc/wwwoffle/scripts/rkn.sh &>${RKN_LOGFILE} && /usr/bin/wwwoffle -config &>>${RKN_LOGFILE}

0 10 * * * /etc/wwwoffle/scripts/rkn.sh &>${RKN_LOGFILE} && /usr/bin/wwwoffle -config &>>${RKN_LOGFILE}

0 18 * * * /etc/wwwoffle/scripts/rkn.sh &>${RKN_LOGFILE} && /usr/bin/wwwoffle -config &>>${RKN_LOGFILE}

@reboot - запуск после перезагрузки, нужен чтоп заполнить ipset, который в ядре и перезагрузку соттветственно не перживает и оказывается пустым.

Purge

{

<*://*/*.css> age = 7w

<*://*/*.js> age = 7w

<*://*/*.json> age = 7w

<*://*/*.png> age = 7w

<*://*/*.jpg> age = 7w

<*://*/*.jpeg> age = 7w

<*://*/*.gif> age = 7w

<*://*/*.ico> age = 7w

<*://*/*.pdf> age = 7w

<*://*/*.swf> age = 7w

use-mtime = no

max-size = -1

min-free = -1

use-url = yes

del-dontget = yes

del-dontcache = yes

age = 4w

compress-age = -1

}

Секция Purge управляет очисткой кеша, здесь определяеца че скока хранить и когда удалять. Тут мы храним всякие картинки пдфки css/js и всю такую хорошо кешируемую дроч 7 недель😊

Ох вроде все по конфигу wwwoffle😊 Вот такая вота партянка по маленькому персональному проксику😊 Вот еще мой полный crontab обслуживающий wwwoffle:

RKN_LOGFILE="/tmp/rkn.log"

BLOCK_LOGFILE="/tmp/adblock.log"

@reboot /usr/bin/sleep 30 && /etc/wwwoffle/scripts/rkn.sh &>${RKN_LOGFILE} && /usr/bin/wwwoffle -config &>>${RKN_LOGFILE}

@daily /etc/wwwoffle/scripts/rkn.sh &>${RKN_LOGFILE} && /usr/bin/wwwoffle -config &>>${RKN_LOGFILE}

0 10 * * * /etc/wwwoffle/scripts/rkn.sh &>${RKN_LOGFILE} && /usr/bin/wwwoffle -config &>>${RKN_LOGFILE}

0 18 * * * /etc/wwwoffle/scripts/rkn.sh &>${RKN_LOGFILE} && /usr/bin/wwwoffle -config &>>${RKN_LOGFILE}

@daily cd /etc/wwwoffle/scripts && /etc/wwwoffle/scripts/convertlists.py -v /etc/wwwoffle/scripts/lists.json /etc/wwwoffle &>${BLOCK_LOGFILE} && /usr/bin/wwwoffle -config &>>${BLOCK_LOGFILE}

@daily /usr/bin/wwwoffle -purge|grep -i del &>/var/log/wwwoffle-purge.log

тоесть тут еще и чистка кеша приплюсовалась.

Основные часто используемые команды 2:

больше мне вроде особо ниче не нужно было, но там есть еще😊

По работе впринципе особых нареканий нет, не смотря на весьма обьемныей списки, к примеру только ркновские домены+урлы 198218 записей, блоклисты 91182 записей, итого под 300 тысяч в сумме переваривает кабудта их нет - запуск, перечитывание конфига, да и просто работа - никаких тормозов не ощющаю как и загрузки cpu, единственное очистка кеша тормозит при этом знатно, точно знаю что из за них - без списков тоже летала. Видимо это из за del-dontget и del-dontcache, но на работу самого прокси это всеравно не влияет никак. Вот тебе и домашний проксик😊 А вот сквид на тех же условиях правда плюсом еще список ip а это еще уже почти 100К записей на данный момент при запуске на парсинге всего этого тупил уже ближе к минуте наверное, тоесть перезапускать или переконфигурить его это был ад и израиль😊 Хотя когда запустица - работал и не чхал😊

Еще оно иногда сегфолтица, хз где и почему но не в управляющем процессе видимо а в порождаемых потоках для обработки соединений, нада будет полазить с дебагером и поправить, но на работе это тоже я не вижу чтоп сказывалось, может падает гдето на закрытии соединения или типа того когда уже все сделано.

UPD - пока дошли руки - отдебажил и поправил это дело попутно написав Как собрать пакет для отладки в Gentoo, а проблема была вот тут:

src/wwwoffles.c:

httpsUrl=ParseRequest(client,&request_head,&request_body);

FreeURL(Url);

Url=CreateURL("https",httpsUrl->hostport,httpsUrl->path,httpsUrl->args,httpsUrl->user,httpsUrl->pass);

FreeURL(httpsUrl);

goto checkrequest;

}

ParseRequest возвращает null если по какой то причине не может распарсить запрос, подозреваю что он не мог потому что по какой то причине соединение обламывалось так как этому предшествовали в логе записи вида

Jul 24 20:30:44 srv wwwoffles[25247]: Nothing to read from the wwwoffle proxy socket; timed out or connection lost?

И парсить ему поэтому вообще тупо нечего😊 И судя по коду это сообщение какрас парсер и выводит😊 А потом мы пытаемся создать какой то Url в строке Url=CreateURL из того что нам вернул ParseRequest, а так как он нихрена не вернул, мы обращаемся к нулевым указателям и получаем сегфолт. Ну и на работе не сказывалось видимо потому что рас соединение обломилось то мы тут ниче собсно поделать то и не можем, правда остается вопрос почему они обламываются но это потом как нибудь, на пенсии повыясняю когда делать нехер будет😊

Решение довольно простое:

diff -ruN wwwoffle-2.9j/src/wwwoffles.c wwwoffle-2.9j-new/src/wwwoffles.c

--- wwwoffle-2.9j/src/wwwoffles.c 2018-07-24 02:12:59.233577980 +0300

+++ wwwoffle-2.9j-new/src/wwwoffles.c 2018-07-24 20:26:41.528637086 +0300

@@ -439,11 +439,19 @@

httpsUrl=ParseRequest(client,&request_head,&request_body);

- FreeURL(Url);

- Url=CreateURL("https",httpsUrl->hostport,httpsUrl->path,httpsUrl->args,httpsUrl->user,httpsUrl->pass);

- FreeURL(httpsUrl);

-

- goto checkrequest;

+ if (httpsUrl) {

+ FreeURL(Url);

+ Url=CreateURL("https",httpsUrl->hostport,httpsUrl->path,httpsUrl->args,httpsUrl->user,httpsUrl->pass);

+ FreeURL(httpsUrl);

+ goto checkrequest;

+ }

+ else {

+ PrintMessage(Warning,"https (SSL) connection error - Request parse error for '%s', '%s', '%s'",Url->hostport, request_head?"HTTP request HEAD":"The HTTP request HEAD was empty",request_body?"HTTP request BODY":"The HTTP request BODY was empty");

+ HTMLMessage(client,500,"WWWOFFLE Server Error",NULL,"ServerError",

+ "error","An https (SSL) connection to specified host (and port) is not established - Cannot parse Request.",

+ NULL);

+ mode=InternalPage; goto internalpage;

+ };

}

else

{

я не вдавался в подробности и логику обработки запросов, а просто сделал проверку что парсер чтото вернул и если нет то кажем стандартную ошибку и вякаем в лог - падения убрались, ну покрайней мере по этой причине, и вроде ниче не сломалось

Впринципе вот эта вот система масок у него тоже очень понравилась. На фоне сквидовских регэкспов, да, они универсальней конечно, но сука с ними головняка в 10 рас больше - то экранируй это экранируй тут чето не срослось там нето тут какой то дебил по русски в листе написал или по китайски или спецсимволов наткал и фсе - оно споткнулось и сразмаху наебнулось, сквид не стартанул, бида пичаль фсе плачут и пиздец😊 А в wwwoffle никаких проблем - все просто как для дебилов и эффективно, и покрывает наверное 90 процентов того что можно накрутить регэкспами в сквиде.

А вот система логгирования это у wwwoffle ад израиль и пиздец😊 и я плачу😊 оно там конечно пишет - что из кеша, что в кеш, и pid процесса, но если много запросов то оно пишет в разнобой и бывает сходу хрен поймеш че к чему, request hit rate/byte hit rate оценить по логам в свете этого тоже та еще задача потому что на 1 запрос куча строк получается, встроенной статистики тоже нет никакой, впринципе не критично, но обидно😊 и с листами тоже нада доработать - оно пишет что попало к примеру в DontGet, но не пишет куда именно в нем, а если он большой то задолбаешся искать, может уровень логгинга поднять и начнет писать, я не пробовал, но я его итак уже приподнял чтоп хотябы видеть что закешировалось что нет что заблочилось. Впрочем сквид тоже не пишет в какой именно регэксп запрос попал - догадайся сам😊

Логгинг я отправил в сислог, у меня syslog-ng, им удобно разруливать такие вещи, примерно вот та:

## WWWOFFLE

destination d_wwwoffled { file("/var/log/wwwoffled.log"); };

filter f_wwwoffled { program("wwwoffled") or program ("wwwoffles"); };

log { source(src); filter(f_wwwoffled); destination(d_wwwoffled); flags(final); };